por alexzumalde » Seg Jan 17, 2011 11:09

por alexzumalde » Seg Jan 17, 2011 11:09

Senhores,

gostaria de achar alguma referência que explique como uma distribuição binomial se comporta através do tempo. Por exemplo, em um experimento, um pequeno programa executa uma série de funções repetidas vezes e sobre essas funções são provocados erros com uma certa frequência. Teriamos então uma série de resultados divididos entre corretos e incorretos (parte dos erros injetados podem não gerar erros no resultado das funções). Minha dúvida principal diz respeito a função de densidade de probabilidade. No experimento, seriam considerados os tempos decorridos até que fosse detectada uma ocorrência de resultado incorreto. Ou seja, eu disparo a execução do programa, disparo a injeção de erros e aguardo até que um resultado incorreto ocorra. Então, registro esses tempos e traço uma função de densidade de probabilidade (termo associado: MTTF - mean time to failure). Eu acredito que a distribuição não seria normal e sim exponencial, mas preciso fundamentar essa premissa. Alguém conheçe um livro que aborde esse tipo de questão ? Seria mesmo um distribuição exponencial ? É possível que dependendo dos parametros eu obtenha uma distribuição normal ?

Eu já levantei esses tempos através de simulação para a usa-los na conclusão do meu mestrado na POLI e a distribuição "parece" ser exponencial. No momento preciso fundamentar tais resultados.

Alex Zumalde

-

alexzumalde

- Novo Usuário

-

- Mensagens: 1

- Registrado em: Seg Jan 17, 2011 10:54

- Formação Escolar: PÓS-GRADUAÇÃO

- Área/Curso: Engenharia

- Andamento: cursando

por Neperiano » Qui Out 27, 2011 15:27

por Neperiano » Qui Out 27, 2011 15:27

Ola

Não sei se é isso, mas se usar confiabilidade.

A questão das falhas ou acertos, acredito que não tenha a ver com a distribuição, ambas podem falhar, tenque cuidar para ver se sua amostra é continua ou númerica (esqueci o nome da outra) porque se não pode ser poisson, tambem.

Se você lagar no google apostila de estatisitca deve ter

Atenciosamente

Sómente os mortos conhecem o fim da guerra

"Platão"

-

Neperiano

- Colaborador Voluntário

-

- Mensagens: 960

- Registrado em: Seg Jun 16, 2008 17:09

- Formação Escolar: GRADUAÇÃO

- Área/Curso: Engenharia de Produção

- Andamento: cursando

Voltar para Estatística

Se chegou até aqui, provavelmente tenha interesse pelos tópicos relacionados abaixo.

Aproveite a leitura. Bons estudos!

-

- [Distribuição normal] com normal reduzida e tabela, dúvida

por MarciaChiquete » Sáb Set 17, 2016 20:38

por MarciaChiquete » Sáb Set 17, 2016 20:38

- 0 Respostas

- 8376 Exibições

- Última mensagem por MarciaChiquete

Sáb Set 17, 2016 20:38

Estatística

-

- Distribuição normal

por lanahwinchester » Qui Jun 30, 2011 13:58

- 2 Respostas

- 5905 Exibições

- Última mensagem por sena

Sáb Jul 30, 2011 12:41

Estatística

-

- Distribuição Normal

por paivadaniel » Qui Jul 14, 2011 17:23

- 0 Respostas

- 4466 Exibições

- Última mensagem por paivadaniel

Qui Jul 14, 2011 17:23

Estatística

-

- Distribuição Normal

por EulaCarrara » Dom Set 11, 2011 17:05

- 1 Respostas

- 5708 Exibições

- Última mensagem por EulaCarrara

Dom Set 11, 2011 17:19

Estatística

-

- Distribuição Normal

por Jean Almeida » Dom Dez 03, 2017 19:47

- 0 Respostas

- 5822 Exibições

- Última mensagem por Jean Almeida

Dom Dez 03, 2017 19:47

Estatística

Usuários navegando neste fórum: Nenhum usuário registrado e 1 visitante

Assunto:

Exercicios de polinomios

Autor:

shaft - Qua Jun 30, 2010 17:30

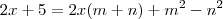

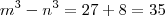

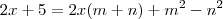

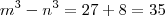

Então, o exercicio pede para encontrar

.

Bom, tentei resolver a questão acima desenvolvendo as duas partes em ( )...Logo dps cheguei em um resultado q nao soube o q fazer mais.

Se vcs puderem ajudar !

Assunto:

Exercicios de polinomios

Autor:

Douglasm - Qua Jun 30, 2010 17:53

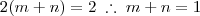

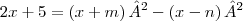

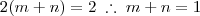

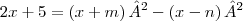

Bom, se desenvolvermos isso, encontramos:

Para que os polinômios sejam iguais, seus respectivos coeficientes devem ser iguais (ax = bx ; ax² = bx², etc.):

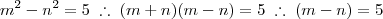

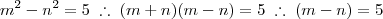

Somando a primeira e a segunda equação:

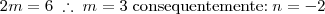

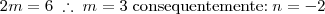

Finalmente:

Até a próxima.

Powered by phpBB © phpBB Group.

phpBB Mobile / SEO by Artodia.

.

.